2025年11月,研究团队同学撰写的三篇论文获AAAI 2026录用。AAAI全称Association for the Advancement of Artificial Intelligence,在中国计算机学会推荐会议列表中被列为A类会议。会议将于2026年1月20-27日在新加坡召开。论文相关介绍如下。

题目:Consensus-Driven Multi-Agent Cognitive Reasoning for Enhancing the Emotional Intelligence of Large Language Models

作者:Geng Tu, Dingming Li, Jun Huang, Ruifeng Xu*

简介:大型语言模型(LLMs)在多种自然语言处理任务中表现出色,但在情绪智能方面仍存在不足。诸如EmoBench等基准测试表明,这一差距主要源于模型在高认知负荷任务上的缺陷,即在复杂社会语境中推理他人的潜在心理状态、意图与情绪的能力不足。为此,我们提出MACRo(Multi-Agent Cognitive Reasoning)框架,一种基于多智能体的认知推理方法。MACRo通过生成由“情境(Situation)—线索(Clue)—思考(Thought)—行动(Action)—情绪(Emotion)”五个要素组成的结构化认知推理链,实现对情绪理解过程的模块化与可解释建模。各要素由专门智能体负责生成,协调智能体对整体逻辑进行验证,并通过共识博弈机制提升多步推理的一致性与可靠性。在EmoBench基准上的实验结果表明,MACRo显著提升了模型的情绪理解与应用能力,并在情绪支持对话等真实社会场景中展现出良好的泛化性能。

题目:MemGuide: Intent-Driven Memory Selection for Goal-Oriented Multi-Session LLM Agents.

作者:Yiming Du*, Bingbing Wang*, Yang He, Bin Liang†, Baojun Wang, Zhongyang Li, Lin Gui, Jeff Z. Pan, Ruifeng Xu†, Kam-Fai Wong†.

简介:论文提出了一个名为MemGuide的新型框架,旨在解决大型语言模型智能体在执行跨多个会话的、面向任务的对话 (Task-Oriented Dialogue, TOD)时的效率低下问题。现有方法主要依赖语义相似性进行记忆检索,但常常忽略了对话的任务意图和信息槽位的连续性,导致用户需要反复提供信息。MemGuide通过一个两阶段的意图驱动记忆选择框架来应对这一挑战:首先,在意图对齐检索阶段,根据当前对话内容生成一个意图假设,然后从以问答形式组织的记忆库中检索与该任务目标一致的记忆单元;接着,在缺失槽位引导过滤阶段,利用一个思维链推理器来识别任务中缺失的信息槽位,并借助一个经过精调的 LLaMA-8B 模型对检索到的记忆进行重排序,从而优先选择那些能够填补当前信息空缺的记忆单元。此外,本文构建了首个用于多会话任务型对话的基准数据集 MS-TOD。实验结果显示,论文提出的MemGuide框架不仅将任务成功率显著提高了11%(从88%到99%),还将完成任务所需的对话轮次平均减少了2.84轮,其性能甚至达到了单会话任务的水平。

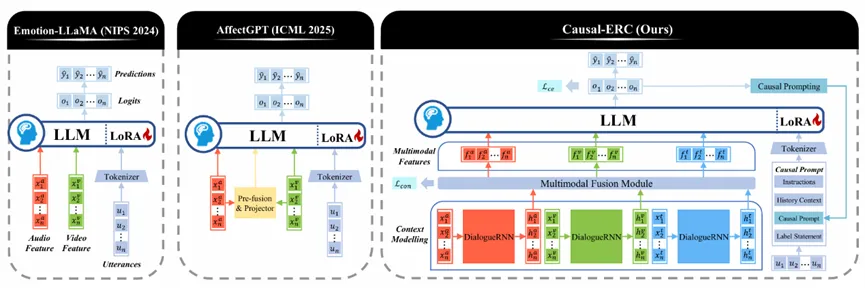

题目:Causal-ERC: A Multimodal Framework with Causal Prompting for Emotion Recognition in Conversations with Large Language Models

题目:Causal-ERC: A Multimodal Framework with Causal Prompting for Emotion Recognition in Conversations with Large Language Models

作者:Ran Jing, Geng Tu, Yice Zhang, Ruifeng Xu*

简介:大语言模型(LLM)的快速发展推动了对话情感识别(ERC)领域的研究。然而,现有基于LLM的ERC方法仅处理文本输入,而基于MLLM的情感识别方法在非对话场景下通常仅进行基本的多模态融合,未能考虑说话人敏感的上下文依赖关系,这限制了它们在ERC任务上的性能。为了有效整合多模态线索并解决其在处理上下文依赖关系方面的局限性,论文提出了一种新颖的基于LLM的框架:Causal-ERC。该框架能够捕捉每种模态的上下文表征,并将其融入LLM中。此外,实验结果表明,LLM在处理长对话时表现不佳。为了提高LLM对长对话的建模能力,论文根据每个话语的因果类型调整相应的因果提示。在两个MERC 数据集上的实验表明,提出的的Causal-ERC框架始终优于现有的最先进方法,并提高了LLM在长上下文场景中的性能。